فایل Robots.txt چیست؟

فایل Robots.txt چیست؟Robots.txt یک فایل متنی است که وب مسترها ایجاد می کنند تا به ربات های وب (به طور معمول ربات های موتور جستجو) نحوه خزیدن و سرک کشیدن در صفحات وب سایت خود را آموزش دهند. فایل robots.txt بخشی از پروتکل خروج ربات ها (REP) است ، گروهی از استانداردهای وب که نحوه خزیدن وب ، دسترسی و فهرست بندی ربات ها را تنظیم می کنند و این مطالب را به کاربران ارائه می دهند. REP همچنین شامل دستورالعمل هایی مانند ربات های متا ، و همچنین دستورالعمل های صفحه ، زیرشاخه- یا سایت در مورد نحوه برخورد موتورهای جستجو با لینک ها (مانند “دنبال کردن” یا “nofollow”) است.

در عمل ، فایل های robots.txt نشان می دهد که آیا برخی از عوامل کاربری (نرم افزار جستجوی وب) می توانند قسمتهایی از وب سایت را بررسی کنند یا خیر. این دستورالعمل های خزنده با “اجازه ندادن” یا “اجازه دادن” به رفتار برخی از کاربران مشخص شده است.

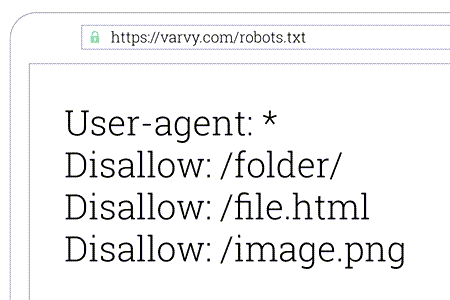

قالب اصلی:

User-agent: [user-agent name]Disallow: [URL string not to be crawled]

این دو خط با هم یک فایل کامل robots.txt در نظر گرفته می شوند – اگرچه یک فایل ربات می تواند شامل چندین خط عامل کاربر و دستورالعمل باشد.

در یک فایل robots.txt ، هر مجموعه از دستورالعمل های عامل کاربر به عنوان یک مجموعه گسسته ظاهر می شوند ، که با یک خط جدا می شوند.

robots.txt چگونه کار می کند؟

موتورهای جستجو دو شغل اصلی دارند:

- خزیدن در وب برای کشف محتوا

- این محتوا را نمایه سازی کنید تا بتواند در اختیار جستجوگرانی باشد که به دنبال اطلاعات هستند.

برای خزیدن سایت ها ، موتورهای جستجو لینکها را دنبال می کنند تا از یک سایت به سایت دیگر بروند – در نهایت ، از طریق میلیاردها لینک و وب سایت خزیده می شوند. این رفتار خزنده گاهی اوقات به عنوان “spidering” شناخته می شود.

پس از ورود به یک وب سایت اما قبل از spidering آن ، خزنده جستجو به دنبال یک فایل robots.txt خواهد بود. اگر یک مورد پیدا کند ، خزنده قبل از ادامه صفحه ابتدا آن فایل را می خواند. از آنجا که فایل robots.txt حاوی اطلاعاتی درباره چگونگی خزیدن موتور جستجو است ، اطلاعات یافت شده در آنجا دستورالعمل های بیشتر خزنده را در این سایت خاص آموزش می دهد. اگر فایل robots.txt فاقد دستورالعمل هایی باشد که فعالیت عامل کاربر را مجاز نمی دانند (یا اگر سایت دارای فایل robots.txt نباشد) ، اطلاعات دیگر موجود در سایت را جستجو می کند.

سینتکس های فنی robots.txt:

سینتکس Robots.txt را می توان “زبان” فایلهای robots.txt دانست. پنج اصطلاح رایج وجود دارد که به احتمال زیاد در فایل robots با آنها روبرو شده اید.که عبارتند از:

- User-agent:خزنده وب خاص که به آن دستورالعمل های خزیدن (معمولاً موتور جستجو) می دهید. لیستی از اکثر نمایندگان کاربر را می توان در اینجا یافت.

- Disallow: دستوری که به عامل کاربر گفته می شود URL خاصی را بررسی نکند. برای هر URL فقط یک خط “Disallow” مجاز است.

- Allow:(فقط برای Googlebot قابل استفاده است)- دستوری که به Googlebot می گوید می تواند به یک صفحه یا زیر پوشه دسترسی پیدا کند حتی اگر صفحه والد یا پوشه فرعی آن مجاز نباشد.

- Crawl-delay:قبل از بارگیری و خزیدن محتوای صفحه ، یک خزنده باید چند ثانیه صبر کند. توجه داشته باشید که Googlebot این دستور را تأیید نمی کند ، اما میزان خزش می تواند در Google Search Console تنظیم شود.

- Sitemap:برای مکان های فراخوانی هر نقشه سایت XML مرتبط با این URL استفاده می شود. توجه داشته باشید که این دستورالعمل فقط توسط Google ، Ask ، Bing و Yahoo پشتیبانی می شود.

robots.txt در کجای یک سایت قرار می گیرد؟

هر زمان که آنها به سایتی مراجعه می کنند ، موتورهای جستجو و سایر ربات های وب-خزنده (مانند خزنده فیس بوک ، Facebot) می دانند که به دنبال یک فایل robots.txt بگردند. اما ، آنها فقط آن فایل را در یک مکان خاص جستجو می کنند: دایرکتوری اصلی . اگر یک نماینده کاربری به وب سایت www.example.com/robots.txt مراجعه کند و فایل robots.txt را در آنجا پیدا نکند ، فرض می کند سایت فاقد یک فایل است و به دنبال خزیدن همه چیز در صفحه (و شاید حتی در کل سایت) است.

چرا به robots.txt نیاز دارید؟

فایل های Robots.txt دسترسی خزنده را به مناطق خاصی از سایت شما کنترل می کنند. اگر شما به طور تصادفی اجازه ندهید Googlebot به جستجوی کل سایت بپردازد ، این بسیار خطرناک است ، اما در برخی از موارد یک فایل robots.txt بسیار مفید است.

برخی موارد استفاده معمول شامل موارد زیر است:

- جلوگیری از نمایش محتوای تکراری در SERP (توجه داشته باشید که روبات های متا اغلب گزینه بهتری برای این کار هستند)

- خصوصی نگه داشتن کل بخشهای یک وب سایت

- جلوگیری از نمایش صفحات نتایج جستجوی داخلی در یک SERP عمومی

- تعیین محل نقشه سایت

- جلوگیری از نمایه سازی موتورهای جستجو در فایل های خاص وب سایت شما (تصاویر ، PDF و غیره)

- مشخص کردن تأخیر خزیدن به منظور جلوگیری از اور لود شدن سرورهای شما هنگام بارگیری همزمان چندین محتوای خزنده ها

اگر در سایت شما هیچ منطقه ای نباشد که بخواهید دسترسی عامل کاربر را به آن کنترل کنید ، ممکن است به هیچ عنوان به یک فایل robots.txt نیازی نداشته باشید.

دیدگاه خود را ثبت کنید

تمایل دارید در گفتگو شرکت کنید؟نظری بدهید!